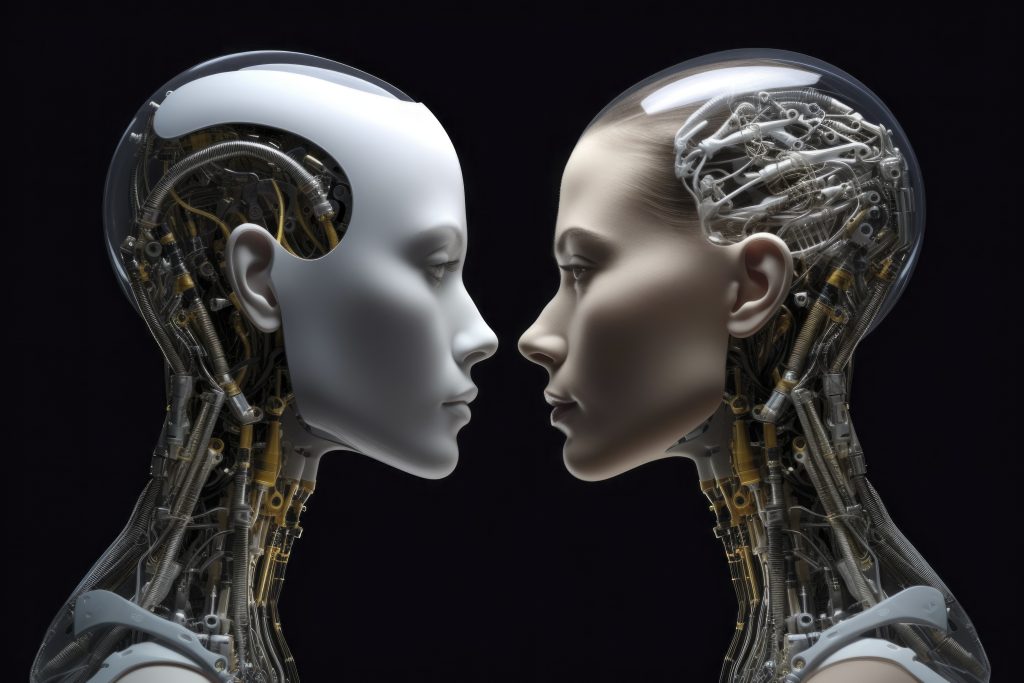

En pleno 2025, la inteligencia artificial ya no es cosa de películas de ciencia ficción. Está en nuestra rutina diaria, aunque a veces ni nos damos cuenta. Desde asistentes virtuales como Siri o Alexa hasta el algoritmo que decide qué reel mostrarte primero en Instagram o qué canción sugerirte en Spotify: la IA vive con nosotros. Pero hay una pregunta que incomoda un poco… ¿por qué solemos representarla como mujer?

Cuando pensamos en asistentes virtuales, casi siempre tienen voces femeninas.

¿Coincidencia? No tanto. Hay algo más profundo detrás de esa elección: los estereotipos de género.

Imagina que le dices “gracias” a Siri después de que te responde. ¿Te pasó? Eso tiene nombre: antropomorfismo. Es la tendencia humana a atribuir características humanas a objetos o tecnologías. Y en IA, eso se nota bastante.

Según un estudio de UNESCO y la Universidad de Stanford, el uso de voces femeninas en asistentes virtuales refuerza estereotipos donde la mujer está para servir o asistir, lo cual perpetúa roles tradicionales en la tecnología. Esto llevó a la UNESCO a lanzar el informe “I’d Blush if I Could” (2019), en el que alertan sobre cómo estas representaciones pueden influir en la percepción que los jóvenes tienen sobre el rol de género en el mundo digital.

Históricamente, se ha relacionado lo femenino con lo asistencial y lo masculino con el liderazgo. En el diseño de IA, esto se ha colado sin que muchos lo cuestionan. ¿Te imaginas si Alexa tuviera voz masculina y se llamará Alejandro? Sería raro solo porque no estamos acostumbrados.

Y esto no es solo una elección estética. Es una decisión que moldea cómo nos relacionamos con la tecnología. Empresas como Q han desarrollado voces neutrales en género, buscando evitar estos sesgos. Q es considerada la primera voz neutral creada para IA, y surgió como una respuesta directa al problema del género en los asistentes virtuales.

Cuando se habla de IA, muchos aún mencionan a Alan Turing, pero seamos sinceros: ¿Cuántas personas saben realmente quién fue? Más relevante para esta generación sería hablar de personas como Joy Buolamwini, investigadora del MIT y fundadora de la Algorithmic Justice League, quien descubrió que muchos sistemas de reconocimiento facial fallaban al identificar correctamente a personas negras y mujeres. Ella es una referente actual que está cambiando el juego en cómo se construye una IA más justa.

Otro ejemplo poderoso es Timnit Gebru, ex-investigadora de ética en IA en Google, quien fue despedida por cuestionar los sesgos en los sistemas que la misma empresa desarrollaba. Su historia se viralizó y abrió debates globales sobre ética, inclusión y diversidad en tecnología.

Entonces, ¿deberíamos construir una IA completamente neutral?

Algunos dirán que sí, otros que es imposible. Pero lo importante es hacer consciente el diseño, cuestionar nuestras decisiones, y sobre todo, darle espacio a voces diversas en el desarrollo de estas tecnologías.

Porque si seguimos entrenando a la IA con los mismos datos de siempre, vamos a obtener los mismos sesgos de siempre. El problema no es la máquina, sino el contenido con el que la alimentamos.

Los jóvenes no son solo usuarios de IA, son los futuros creadores de esta tecnología. Por eso es tan importante que entiendan cómo operan estos sesgos. Según un informe de PwC, el 85% de los trabajos del 2030 aún no existen, y muchos estarán relacionados con IA. Si seguimos diseñando con prejuicios, el futuro no será tan prometedor.

En lugar de preguntarnos si la IA es hombre o mujer, mejor preguntemos: ¿cómo queremos que nos represente esta tecnología? ¿Reflejando los errores del pasado o liderando hacia una sociedad más justa e inclusiva?

La inteligencia artificial no tiene género, pero la forma en la que la diseñamos sí tiene valores. Y esos valores deben ser debatidos, cuestionados y reconstruidos. El verdadero potencial de la IA no está en parecerse a nosotros, sino en ayudarnos a ser mejores.